熱門資訊> 正文

剛剛,DeepSeek最新發文,V3/R1訓練細節全公開,信息量巨大

2025-09-01 20:03

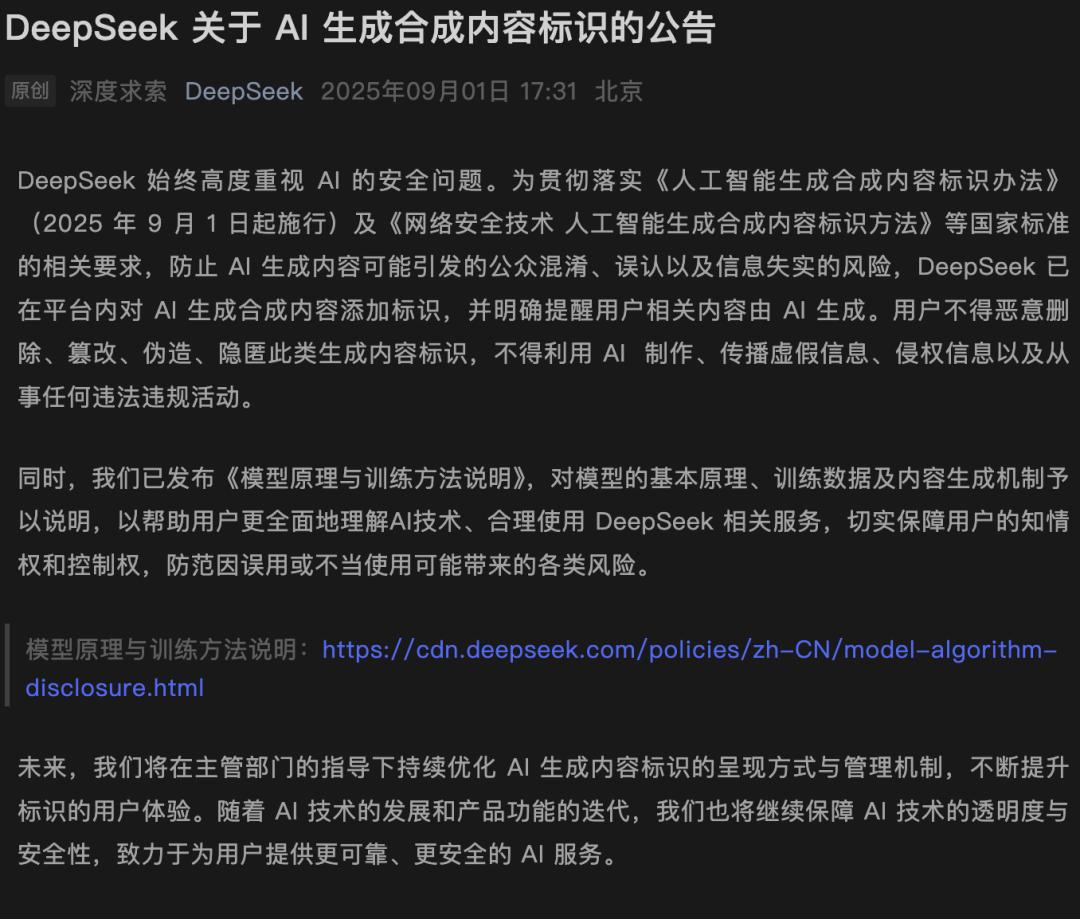

新規第一天,DeepSeek第一時間站出來了!接下來,所有自家AI生成內容,統統標出「AI身份」。更勁爆的是,DeepSeek主動「交底」V3/R1的模型訓練細節。

今天,網信辦《人工智能生成合成內容標識辦法》正式生效。

其中,第四條要求:對符合要求的AI生成合成內容添加顯式標識。

緊跟最新政策,DeepSeek出手了。

剛剛,DeepSeek官微發佈了最新迴應公告——凡是AI生成的內容,都會清楚標註「AI生成」。

它還鄭重提醒,用户嚴禁惡意刪除、篡改、隱匿標識,更別提用AI傳播、製作虛假信息。

此外,這次還發布了《模型原理與訓練方法説明》,可以一瞥DeepSeek的技術路徑。

接下來,深扒一下DeepSeek V3/R1的一些訓練細節。

傳送門:https://cdn.deepseek.com/policies/zh-CN/model-algorithm-disclosure.html

迴應新要求,DeepSeek公開技術説明

DeepSeek主要介紹了大模型的訓練和推理階段,包括預訓練、優化訓練(微調)以及訓練數據等。

不同大模型的神經網絡架構

模型訓練

模型訓練階段即模型的開發階段:通過設計好的深度神經網絡架構和訓練方法,開發人員開發出可被部署使用的模型。

模型由多層神經網絡組成,不同的架構直接影響模型的性能。此外,模型性能也受參數規模的制約,而訓練的目的就是找到具體的參數值。

目前,大模型的參數規模數以億計。最新的DeepSeek-V3-0324,參數總量為6850億。

在訓練過程中,這些參數通過梯度下降算法迭代優化。

這次,DeepSeek把模型訓練分為預訓練和優化訓練兩個環節。

預訓練:預訓練目標是通過數據訓練模型,使模型掌握通用的語言理解與生成能力。

優化訓練:也稱為微調,是在預訓練模型的基礎上通過特定任務的數據進一步調整模型參數,使模型適應實際應用場景。

在預訓練階段,模型通過大規模自監督學習,從文本數據中學習語言模式與知識關聯。預訓練完成后,模型能理解並生成連貫的文本,但還不會精準地回答問題或執行任務,因此需要進一步的訓練微調。

在優化訓練階段,模型一般通過SFT、RL等方法,學會根據指令回答問題,符合人類的偏好和需求,並激發在特定領域的專業能力。

經過優化訓練的模型能更好地滿足實際需求,可被部署使用。

深挖訓練「內幕」,煉出最強大腦

DeepSeek模型的能力,是建立在高質量、大規模、多樣化的數據之上。

在「預訓練階段」和「優化訓練階段」,各有不同。

預訓練階段

在預訓練階段,主要使用了兩類數據:

互聯網公開可用的信息,比如網頁、公開文檔等。

與第三方合作獲取許可的數據

需要強調的是,在此階段,根本無需獲取個人信息用於訓練,DeepSeek不會有意關聯至任何特定賬户和個人,更不會主動將其用於訓練模型。

不過,預訓練數據規模過於龐大,可能偶然包含了一些個人信息。

對此,DeepSeek會通過技術手段,盡力篩查並移除這些信息,確保數據「乾乾淨淨」。

爲了保證數據質量、安全、多樣,他們還打造了一套硬核數據治理流程——

首先,通過「過濾器」自動剔除仇恨言論、色情低俗、暴力、垃圾信息,以及可能侵權的原始數據。

其次,通過算法+人工審覈,識別並降低數據中的統計性偏見,讓模型更公平、更客觀。

優化訓練階段

到了優化訓練階段,一般需要通過人工或自動化的方式構造、標註一批問答對數據來對模型進行訓練。

DeepSeek這次表示:這些問答對數據是由研究團隊生成提供的,其中少部分數據的構造可能會基於用户的輸入。

在DeepSeek-R1訓練中,研究人員直接提示模型生成包含反思和驗證的詳細答案;收集並整理DeepSeek-R1-Zero的輸出,使其具有可讀性;以及通過人工註釋者的后期處理來提高數據質量

如涉及利用用户的輸入構造訓練數據,DeepSeek會對數據進行安全加密技術處理、嚴格的去標識化和匿名化處理,從而儘可能避免訓練數據關聯到任何特定個人,且不會在模型給其他用户的輸出中帶有個人信息,更不會將其用於用户畫像或個性化推薦。

同時,DeepSeek為用户提供了選擇退出的權利。

爲了確保模型的安全性,在模型優化訓練階段,DeepSeek構造了專門的安全數據對模型進行安全對齊,教會模型的回覆符合人類的價值觀,增強模型內生的安全能力。

模型推理

模型的推理階段即模型被部署提供服務。

模型訓練完成並被部署后,可以通過對輸入信息進行編碼和計算來預測下一個token,從而具備文本生成和對話等能力。

部署后的模型能夠熟練執行基於文本生成的廣泛多樣的任務,並可以集成到各種下游系統或應用中。

具體到DeepSeek的產品服務,基於用户的輸入,模型採用自迴歸生成方式,基於輸入的上下文內容,通過概率計算預測最可能的接續詞匯序列。

推理完成后,模型輸出相應的內容作為響應,包括文字、表格和代碼等。

此並非簡單檢索或「複製粘貼」訓練數據中的原始文本,模型也並未存儲用於訓練的原始文本數據副本,而是基於對語言結構和語義關係的深度理解,動態生成符合語境的回答。

DeepSeek這次還強調模型開源。

我們通過開源平臺對外公開發布了所有模型的權重、參數以及推理工具代碼等,並採用寬松的MIT協議,供使用者自由、免費下載部署使用。

同時,DeepSeek發佈各模型的完整技術報告,供社區和研究人員參考,並幫助公眾更深入地瞭解每個模型的技術原理和細節。

LLM致命幻覺,全周期硬核對抗

毋庸置疑,當前AI發展還在早期階段,存在無法避免的侷限性。

若是再被加以濫用,將會帶來嚴重的后果。

侷限性

AI往往會生成錯誤、遺漏,或不符合事實的內容,這種現象統一稱之為「幻覺」。

這個問題,是整個AI行業面臨的挑戰。

對此,DeepSeek正通過一些技術手段降低幻覺率,包括高質量的訓練數據、優化對齊策略、RAG等,但現階段依無法完全消滅。

同時,他們還在歡迎頁、生成文本的末尾,以及交互界面底部,添加顯著的提示標識。

特別提醒用户——內容由人工智能生成,可能不準確。

因此,AI生成的內容僅供參考,所有人不應將輸出的內容作為專業建議。

尤其是,在醫療、法律、金融等專業領域,DeepSeek不提供任何建議或承諾,專業的事兒還得找專業的人。

濫用風險

AI技術本身是中立的,但濫用可能帶來隱私保護、版權、數據安全、內容安全、偏見歧視等風險。

DeepSeek對此也是高度重視,採取了一系列硬核措施,貫穿了模型研發、訓練、部署的全生命周期。

制定內部風險管理制度

開展模型安全性評估

進行紅隊測試

增強模型和服務透明度等

更重要的是,DeepSeek還賦予了用户知情權、選擇權、控制權——

你可以查詢服務的基本信息、拒絕其數據用於模型訓練、刪除其歷史數據等。

參考資料:

https://cdn.deepseek.com/policies/zh-CN/model-algorithm-disclosure.htmlDeepSeek 關於 AI 生成合成內容標識的公告

本文來自微信公眾號「新智元」,作者:新智元,編輯:KingHZ 桃子,36氪經授權發佈。

推薦文章

美股機會日報 | 凌晨3點!美聯儲將公佈1月貨幣政策會議紀要,納指期貨漲近0.5%;13F大曝光!巴菲特連續三季減持蘋果

美股機會日報 | 阿里發佈千問3.5!性能媲美Gemini 3;馬斯克稱Cybercab將於4月開始生產

港股周報 | 中國大模型「春節檔」打響!智譜周漲超138%;鉅虧超230億!美團周內重挫超10%

一周財經日曆 | 港美股迎「春節+總統日」雙假期!萬億零售巨頭沃爾瑪將發財報

從軟件到房地產,美國多板塊陷入AI恐慌拋售潮

Meta計劃為智能眼鏡添加人臉識別技術

危機四伏,市場卻似乎毫不在意

財報前瞻 | 英偉達Q4財報放榜在即!高盛、瑞銀預計將大超預期,兩大關鍵催化將帶來意外驚喜?