热门资讯> 正文

一文看懂最强大模型排名:6大关键指标全透视百模大战

2024-07-11 14:29

谁是最强大模型?该如何评判?

从千团大战,到共享之战,再到如今的大模型之争,百模大战正如火如荼上演,孰优孰劣,各执一词。今天我会结合第三方平台的数据对目前通用的大模型进行一次五大维度能力的排序:对AI模型在关键性能指标(包括质量、价格、输出速度、延迟、上下文窗口等)进行比较和分析。六大关键指标亮点:

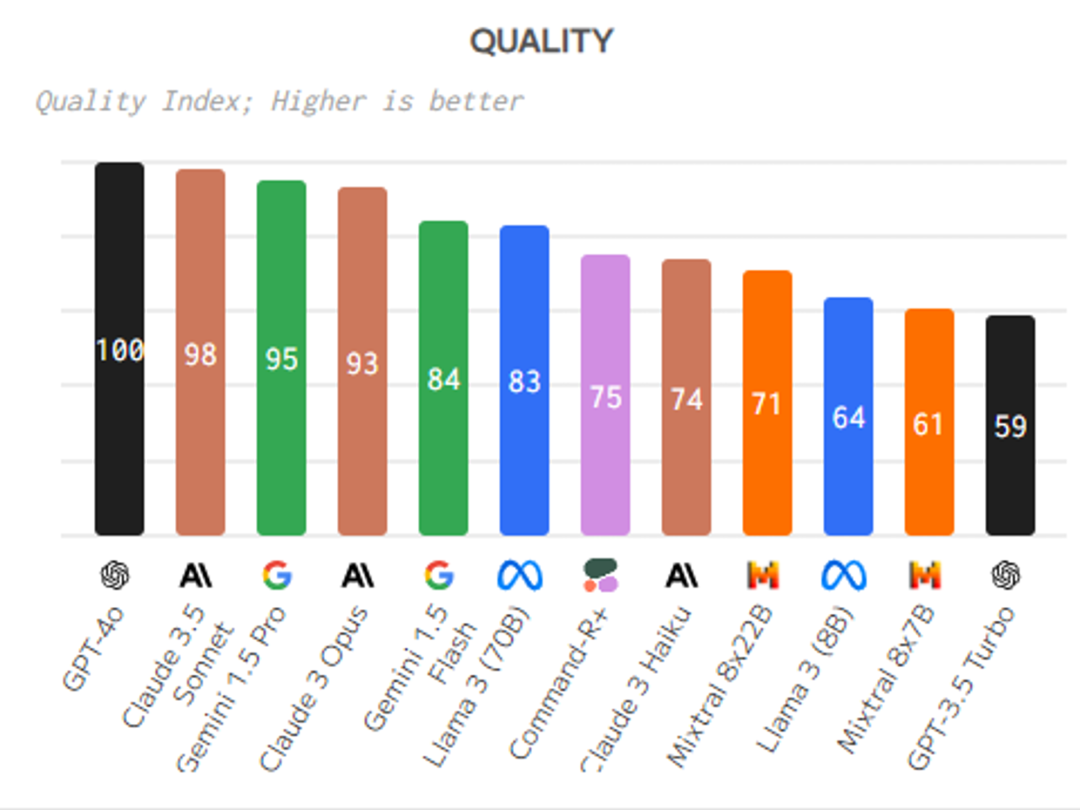

质量指数:用于评估模型在各种任务和基准测试中的性能表现,得分越高表示模型表现越好。

输出速度:衡量模型生成输出的速度,输出速度越高表示模型处理能力越强。

价格:表示模型的成本,价格越低表示性价比越高。

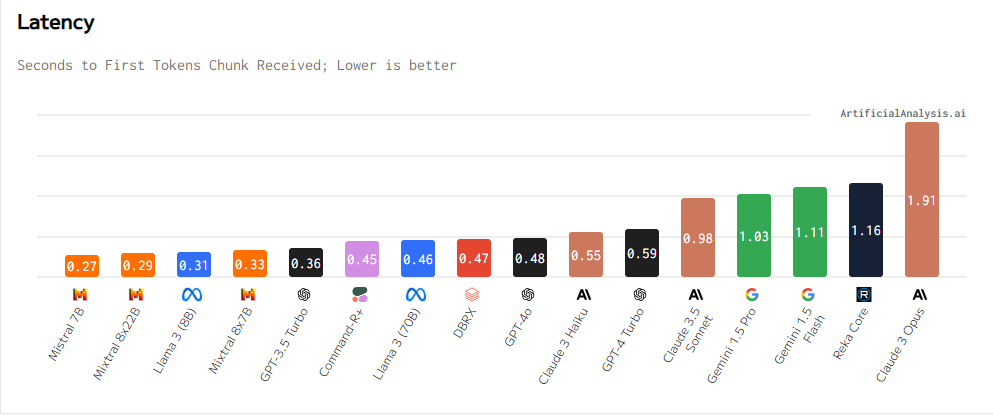

延迟:指从发送请求到接收到第一个响应之间的时间间隔,延迟越低表示模型响应速度越快。

上下文窗口:表示模型在处理文本时能够同时考虑的标记数量的限制,较大的上下文窗口有助于模型更好地理解和生成文本。

总响应时间:从发送请求到接收到完整输出结果所经历的时间,综合考虑了延迟和输出速度等因素。

这些关键指标可以帮助用户全面评估和比较不同AI模型的性能和特点,从而选择最适合特定任务需求的模型。

- 质量指数越高越好。质量与输出速度、价格之间存在权衡。质量指数代表在聊天机器人领域、MMLU和MT-Bench中的相对性能。

- 速度指标代表模型生成标记时的每秒标记数。

- 价格指标代表每百万标记的价格。模型之间存在速度差异,质量和价格不一定成正比。

- 总响应时间代表接收100个标记输出所需的时间,由延迟和输出速度指标计算。

- 延迟指标代表接收第一个标记所需的时间。总响应时间随着输入标记长度的增加而变化。速度和价格之间存在权衡。延迟和输出速度之间存在关系。

- 总响应时间随着输入标记长度的增加而变化。模型之间存在速度差异。总响应时间代表接收100个标记输出所需的时间。模型之间存在总响应时间的差异。

根据不同指标对AI模型进行排序如下:第一,质量指数:得分越高越好,大型AI模型的质量指数通常是根据模型在各种基准测试和任务中的表现来评估的。质量指数得分越高表示模型在各方面的性能表现越好。这些性能指标可能包括模型在自然语言处理、文本生成、对话系统等任务中的准确性、流畅性、逻辑性等方面的表现。较高的质量指数意味着模型在处理各种任务时具有更好的性能和效果。在选择使用大型模型时,质量指数是一个重要的参考指标,可以帮助用户评估模型的整体表现和适用性。

- GPT-4o

- Claude 3.5 Sonnet

- Gemini 1.5 Pro

- GPT-4 Turbo

- Claude 3 Opus

- Gemini 1.5 Flash

- Llama 3 (70B)

- Command-R+

- Claude 3 Haiku

- Mixtral 8x22B

- Llama 3 (8B)

- Mixtral 8x7B

- GPT-3.5 Turbo

- Gemini 1.5 Flash

- Llama 3 (8B)

- Claude 3 Haiku

- Mistral 7B

- Mixtral 8x7B

- GPT-4o

- Claude 3.5 Sonnet

- GPT-3.5 Turbo

- Llama 3 (8B)

- Gemini 1.5 Flash

- Mixtral 8x7B

- Claude 3 Haiku

- GPT-3.5 Turbo

- Llama 3 (70B)

- Mixtral 8x22B

- GPT-4 Turbo

- Claude 3 Opus

- Gemini 1.5 Pro

- Gemini 1.5 Flash

- Claude 3.5 Sonnet

- Claude 3 Opus

- Claude 3 Haiku

- GPT-4o

- GPT-4 Turbo

- Command-R+

- Reka Core

- Llama 3 (8B)

- Mistral 7B

- Claude 3 Haiku

- Gemini 1.5 Flash

- GPT-3.5 Turbo

- Mixtral 8x7B

- GPT-4o

- Claude 3.5 Sonnet

第六,延迟排序:

此外,根据延迟(秒数)对AI模型进行排序如下:大型AI模型通常具有较高的延迟,因为这些模型需要处理更多的参数和更复杂的计算。大型模型通常需要更多的计算资源和时间来处理输入数据并生成输出。因此,与小型模型相比,大型模型的延迟可能会更长。然而,一些大型模型可能会通过优化和并行化处理等技术来降低延迟,以提高性能和效率。在选择使用大型模型时,需要权衡其性能和延迟之间的关系,以满足特定应用的需求。

- Mistral 7B

- Mixtral 8x22B

- Llama 3 (8B)

- Mixtral 8x7B

- GPT-3.5 Turbo

- Command-R+

- Llama 3 (70B)

- DBRX

- GPT-4o

- Claude 3 Haiku

- GPT-4 Turbo

- Claude 3.5 Sonnet

- Gemini 1.5 Pro

- Gemini 1.5 Flash

- Reka Core

- Claude 3 Opus

======================================

根据不同指标的排序,可以更清晰地了解各个AI模型在关键性能指标上的表现。

根据排序结果,可以总结六大关键指标的亮点如下:

- 质量指数:GPT-4o和Claude 3.5 Sonnet在质量指数方面表现最好,得分较高,显示出在各种任务和基准测试中的优异性能。

- 输出速度:Gemini 1.5 Flash和Llama 3 (8B)在输出速度方面表现突出,具有较高的处理能力和速度。

- 价格:Llama 3 (8B)和Gemini 1.5 Flash在价格方面表现较好,价格较低,性价比较高。

- 延迟:Mistral 7B和Mixtral 8x22B在延迟方面表现较好,响应速度较快。

- 上下文窗口:Gemini 1.5 Pro和Gemini 1.5 Flash具有较大的上下文窗口,有助于模型更好地理解和生成文本。

- 总响应时间:Llama 3 (8B)和Mistral 7B在总响应时间方面表现突出,能够快速生成完整的输出结果。

综合以上亮点总结,用户可以根据具体需求和重点关注的指标选择最适合的AI模型。

风险提示: 投资涉及风险,证券价格可升亦可跌,更可变得毫无价值。投资未必一定能够赚取利润,反而可能会招致损失。过往业绩并不代表将来的表现。在作出任何投资决定之前,投资者须评估本身的财政状况、投资目标、经验、承受风险的能力及了解有关产品之性质及风险。个别投资产品的性质及风险详情,请细阅相关销售文件,以了解更多资料。倘有任何疑问,应征询独立的专业意见。

推荐文章

美股机会日报 | 市场风格趋变?美银称接下来是小盘股的天下;金价重回5000美元上方,贵金属板块盘前齐升

新股暗盘 | 乐欣户外飙升超70%,中签一手账面浮盈4345港元;爱芯元智微涨超0.2%

高盛预计英伟达Q4营收达673亿美元 给出250美元目标股价

财报大跌背后:微软正在进行一场昂贵但精准的“利润置换”

港股IPO持续火热!下周6股排队上市,“A+H”占比一半

港股周报 | “AI红包大战”厮杀!腾讯周内暴跌近10%、阿里重挫8%,南下资金出手560亿港元大举抄底

美股机会日报 | 止跌企稳!纳指期货盘前涨约0.5%,有分析称美股连遭重挫后或回升;亚马逊盘前大跌超8%

一周财经日历 | 事关降息!美国1月非农、CPI数据下周公布;恒指季检结果下周五揭晓